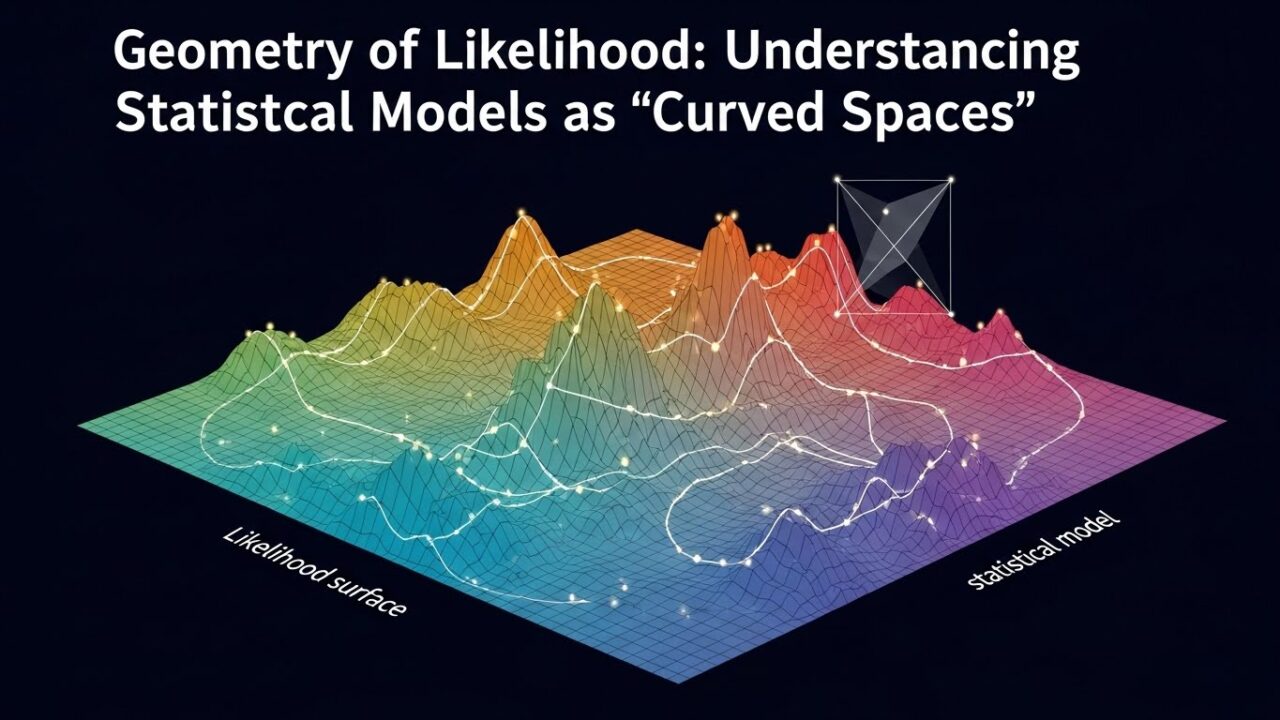

尤度の幾何学:統計モデルを“曲がった空間”として理解する

記事の目次

Toggleはじめに

統計モデルを「曲がった空間」として扱う視点は、情報幾何(Information Geometry)と呼ばれる分野で体系化されています。

これは、確率分布の集合を多様体(manifold)として捉え、その上で距離・角度・曲率といった幾何学的概念を導入するアプローチです。

この視点を持つと、次のような疑問に自然な答えが与えられます。

- なぜフィッシャー情報量は重要なのか

- KL ダイバージェンスは「距離」としてどのように機能するのか

- ニュートン法や自然勾配法がなぜ効率的なのか

- 深層学習の最適化に幾何学がどう関係するのか

この記事では、これらを直感的に理解できるよう、数式を交えながら解説していきます。

統計モデルを多様体として扱う:情報幾何の基本発想

統計モデルは「点の集合」ではなく「曲がった空間」です

確率分布 \(p(x\mid \theta )\) をパラメータ \(\theta\) で表すとき、

\(\theta\) の取りうる値の集合は通常 \(\mathbb{R^{d}}\) の部分集合です。

しかし、確率分布の集合そのものは、一般に曲がった幾何構造を持ちます。

たとえば、正規分布族

\[p(x\mid \mu ,\sigma )\]

は 2 次元パラメータ空間を持ちますが、その空間はユークリッド平面ではなく、曲率を持つリーマン多様体として振る舞います。

フィッシャー情報量=計量(metric)としての意味

● フィッシャー情報量とは何か

確率モデル \(p(x\mid \theta )\) に対し、フィッシャー情報量行列は

\[I(\theta )=\mathbb{E}\left[ \left( \frac{\partial }{\partial \theta }\log p(X\mid \theta )\right) \left( \frac{\partial }{\partial \theta }\log p(X\mid \theta )\right) ^{\top }\right]\]

で定義されます。

これは「パラメータを微小に動かしたとき、分布がどれだけ変化するか」を測る量です。

● 計量(metric)としての解釈

リーマン多様体では、距離の微小量は

\[ds^2=g_{ij}(\theta )d\theta _id\theta _j\]

で与えられます。

情報幾何では、この計量テンソル \(g_{ij}\) に フィッシャー情報量を使います。

\[g_{ij}(\theta )=I_{ij}(\theta )\]

つまり、フィッシャー情報量は確率分布空間の「ものさし」なのです。

KL ダイバージェンス=距離の 2 次近似

KL ダイバージェンスは

\[D_{\mathrm{KL}}(p_{\theta }\| p_{\theta +d\theta })\]

で定義されますが、これは一般には距離ではありません(非対称です)。

しかし、微小変化 \(d\theta\) に対して 2 次近似すると

\[D_{\mathrm{KL}}(p_{\theta }\| p_{\theta +d\theta })=\frac{1}{2}d\theta ^{\top }I(\theta )d\theta +o(\| d\theta \| ^2)\]

となります。

つまり、KL ダイバージェンスの局所近似はフィッシャー計量に一致します。

ニュートン法・自然勾配法の幾何学的理解

● ニュートン法は「曲がった空間での最急降下」です

最尤推定では、対数尤度 \(\ell (\theta )\) を最大化します。

ニュートン法は

\[\theta _{t+1}=\theta _t-H^{-1}(\theta _t)\nabla \ell (\theta _t)\]

で更新します。

ここで H はヘッセ行列です。

情報幾何の視点では、これは

- 曲がった空間での最急降下方向を補正する操作

- 局所的な曲率(ヘッセ行列)を使って距離を補正する方法

と解釈できます。

● 自然勾配法(Natural Gradient)

深層学習で注目される自然勾配法は

\[\theta _{t+1}=\theta _t-\eta I(\theta _t)^{-1}\nabla L(\theta _t)\]

で更新します。

これは、ユークリッド勾配ではなく、確率分布空間の“真の勾配”を使う方法です。

- 通常の勾配:パラメータ空間の直線距離で下降

- 自然勾配:確率分布の距離(KL)で下降

そのため自然勾配は、

- スケール不変

- パラメータ化に依存しない

- 局所的に最も効率的な方向を選ぶ

という性質を持ちます。

深層学習の最適化における応用

深層学習のパラメータ空間は非常に高次元で、

通常の勾配法では「曲がり」によって学習が遅くなることがあります。

情報幾何の視点を持つことで、次のような理解が得られます。

● パラメータ空間は極端に曲がっています

ニューラルネットのパラメータ空間は、

重みのスケールや活性化関数の性質により、強い曲率を持ちます。

自然勾配法は、この曲率を補正します。

● KL ダイバージェンスを用いた正則化

深層学習では、KL を使った正則化(例:変分推論、VAE)が多用されます。

これは、KL が局所的に距離として働くという情報幾何の性質に基づいています。

● Fisher-Rao 距離と最適化

自然勾配法は Fisher-Rao 距離に基づく最適化であり、

これは深層学習の学習効率を大きく改善する可能性があります。

実際、K-FAC(Kronecker-Factored Approximate Curvature)などの手法は

自然勾配の近似として成功しています。

情報幾何が与える“視点の変化”

情報幾何を学ぶことで、統計モデルや深層学習の最適化が

単なる計算ではなく、幾何学的な構造を持つ現象として見えてきます。

- フィッシャー情報量 → 空間の計量

- KL ダイバージェンス → 距離の近似

- ニュートン法 → 曲率を補正した最急降下

- 自然勾配法 → 真の勾配方向

- 深層学習 → 高次元の曲がった空間での探索

この視点は、理論的に美しいだけでなく、実際の最適化アルゴリズムの改善にも直結します。

まとめ

本記事では、統計モデルを「曲がった空間」として理解する情報幾何の基礎的な考え方を紹介しました。統計モデルはリーマン多様体として扱うことができ、その空間の計量としてフィッシャー情報量が働くことを説明しました。また、KL ダイバージェンスが距離の 2 次近似として機能することから、確率分布間の“距離”を測る道具として自然に解釈できることを示しました。さらに、ニュートン法や自然勾配法といった最適化手法が、空間の曲率や計量を考慮した幾何学的に自然な更新則であることを解説し、深層学習のような高次元で複雑なモデルにおいても情報幾何の視点が有効であることを述べました。これらの内容を通じて、統計学・機械学習・深層学習に共通する基盤として、情報幾何が今後ますます重要な役割を果たすことを強調しました。