AIC/BICの“本質”を数理統計から理解する:KL情報量・事後確率との接続

記事の目次

Toggleはじめに

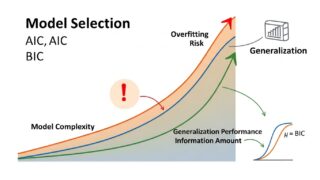

モデル選択の現場では、AIC や BIC は「とりあえず計算する指標」として扱われがちです。しかし、これらの基準が何を最適化しているのか、そしてどのような理論的背景を持つのかを理解すると、モデル選択の判断が格段に洗練されます。

この記事では、AIC/BIC の導出を「公式の暗記」ではなく、

・AIC=予測誤差(KL情報量)を最小化する基準

・BIC=事後確率最大化(ベイズモデル選択)に対応する基準

として捉え直し、実務での誤用や判断のポイントまで丁寧に解説します。

AIC,BICに関する基礎的な内容は下記で解説しておりますので、是非ご一読ください。

AIC/BIC は何を最適化しているのか?

■ AIC:予測性能(KL情報量)を最小化する

AIC の本質は「真の分布 f と、モデル\( g_{\theta }\) の距離(KL情報量)を最小化する」ことです。

真の分布 \(f(x)\) とモデル \(g_{\theta }(x)\) の距離を測る尺度:

\[\mathrm{KL}(f,g_{\theta })=\int f(x)\log \frac{f(x)}{g_{\theta }(x)}dx\]

これは「モデルが真の分布をどれだけうまく近似できているか」を測る指標。

● AIC の導出(直感)

AIC は次の形で定義されます:

\[\mathrm{AIC}=-2\log L(\hat {\theta })+2k\]

ここで

- \(L(\hat {\theta })\):最尤推定値での尤度

- \(k\):推定パラメータ数

なぜ +2k が必要なのか?

→ 尤度最大化は「当てはまり」を最大化するが、複雑なモデルほど当てはまりが良くなるため、過学習を補正するためのペナルティが必要。

AIC は、KL情報量の期待値を最小化する推定量を求める過程で、

「尤度のバイアス補正項」= 2k

が自然に現れる。

■ BIC:事後確率最大化(ベイズモデル選択)

BIC は次の形:

\[\mathrm{BIC}=-2\log L(\hat {\theta })+k\log n\]

AIC と似ているが、ペナルティが \(\log n\) で増える点が重要。

● BIC の導出(直感)

ベイズモデル選択では、モデル M の事後確率を最大化する:

\[p(M\mid \mathrm{data})\propto p(\mathrm{data}\mid M)p(M)\]

このうち

\[p(\mathrm{data}\mid M)=\int p(\mathrm{data}\mid \theta ,M)p(\theta \mid M)d\theta\]

をラプラス近似すると、

\[-2\log p(\mathrm{data}\mid M)\approx -2\log L(\hat {\theta })+k\log n\]

これが BIC の式そのもの。

- モデルの事後確率を最大化する基準

- データ数が増えるとペナルティが強くなる

- 大標本での一貫性(consistency)を持つ

→ 真のモデルが候補に含まれていれば、BIC は必ずそれを選ぶ

AIC=予測性能、BIC=真のモデル選択

| 基準 | 最適化対象 | 特徴 | 適した用途 |

| AIC | KL情報量(予測誤差) | 複雑なモデルを選びやすい | 予測重視 |

| BIC | モデルの事後確率 | シンプルなモデルを選びやすい | 真のモデル推定 |

実務での誤用と対策

■ 誤用1:AIC で過度に複雑なモデルを選ぶ

AIC はペナルティが弱いため、説明変数が多い回帰モデルや高次多項式で過剰適合しやすい。

- AICc(小標本補正 AIC)を使う

\[\mathrm{AICc}=\mathrm{AIC}+\frac{2k(k+1)}{n-k-1}\] - クロスバリデーションと併用する

- 変数選択では LASSO など正則化を併用

誤用2:BIC を「予測性能の良いモデル」と誤解する

BIC は「真のモデル選択」に強いが、予測性能では AIC に劣ることが多い。

- 予測タスクでは AIC または CV を優先

- BIC は「説明の簡潔さ」を重視する場面で使う

実データで AIC/BIC が異なる結論を出すとき

これは実務で非常に頻繁に起こる。

例:線形回帰で次数を選ぶとき

- AIC → 4次多項式

- BIC → 2次多項式

のように結論が分かれる。

■ 判断のポイント

① 目的が「予測」なら AIC

- 将来データの予測誤差を最小化したい

- モデルが真である必要はない

- CV と整合的

② 目的が「解釈」なら BIC

- どの変数が本当に効いているか知りたい

- モデルの簡潔性を重視

- 大標本での一貫性が魅力

③ 両者の差が小さい場合は「どちらでもよい」

AIC と BIC の差が 2〜4 程度なら、実質的には同程度の支持と考えてよい。

④ モデル平均化(Model Averaging)という選択肢

AIC/BIC を重みとして、複数モデルの予測を平均する方法:

\[\hat {y}=\sum _mw_m\hat {y}_m\]

- AIC重み

- BIC重み

- ベイズモデル平均(BMA)

などがある。

まとめ

AIC と BIC は、単なる「モデル選択のための数値」ではなく、それぞれが明確に異なる統計的思想を背景に持つ基準です。AIC は、真の分布とモデルの距離を測る KL 情報量を最小化するという観点から導かれ、将来データに対する予測性能を重視します。一方で BIC は、ベイズモデル選択における事後確率最大化に対応し、データ数が増えるほど複雑なモデルを強く罰することで、真のモデルを選び抜くことに焦点を当てています。

この違いは、実務での判断にも直結します。予測精度を最優先するなら AIC(特に小標本では AICc)が適しており、モデルの解釈性や構造の簡潔さを重視するなら BIC が有効です。両者が異なる結論を示す場面は珍しくありませんが、そのときこそ「何を目的とした分析なのか」を明確にすることが重要です。また、AIC が複雑なモデルを選びすぎる、BIC が単純化しすぎるといった誤用も起こりやすく、クロスバリデーションやモデル平均化といった補完的な手法を併用することで、より堅牢な判断が可能になります。

AIC/BIC の本質を理解することは、モデル選択を「数値の比較」から「統計的思想に基づく判断」へと引き上げます。予測か、解釈か、真の構造か。目的に応じて基準を使い分けることで、分析の質は大きく向上します。AIC/BIC を“暗記して使う”段階から、“理解して選ぶ”段階へ進むことこそ、統計モデリングをより深く、より実践的に活かすための第一歩と言えるでしょう。